To 2025, ήταν μια σημαντική χρονιά για τη δημιουργία βίντεο με τεχνητή νοημοσύνη. Τους τελευταίους εννέα μήνες, η OpenAI έκανε το Sora δημόσιο, η Google DeepMind λάνσαρε το Veo 3, ενώ η startup Runway παρουσίασε το Gen-4. Όλα αυτά μπορούν να παράγουν βίντεο που είναι (σχεδόν) αδύνατο να ξεχωρίσει κανείς από πραγματικά γυρισμένο υλικό ή CGI animation, σημειώνει το MIT Technology Review.

Φέτος, η Netflix παρουσίασε για πρώτη φορά ένα AI οπτικό εφέ στη σειρά της The Eternaut, σηματοδοτώντας την πρώτη χρήση της τεχνολογίας δημιουργίας βίντεο σε μαζικής απήχησης τηλεοπτική παραγωγή. Βέβαια, τα κλιπ που βλέπουμε σε demo reels είναι προσεκτικά επιλεγμένα, για να δείξουν τις δυνατότητες των μοντέλων στην κορυφή τους. Αλλά με την τεχνολογία πλέον διαθέσιμη σε περισσότερους χρήστες από ποτέ — το Sora και το Veo 3 είναι προσβάσιμα στις εφαρμογές ChatGPT και Gemini για συνδρομητές — ακόμη και ο πιο «απλός» δημιουργός μπορεί τώρα να φτιάξει κάτι εντυπωσιακό.

Η αρνητική πλευρά, αναφέρει το MIT Technology Review, είναι ότι οι δημιουργοί ανταγωνίζονται με χαμηλής ποιότητας AI περιεχόμενο, ενώ τα social media γεμίζουν με πλαστά ειδησεογραφικά βίντεο. Επιπλέον, η δημιουργία βίντεο με AI καταναλώνει τεράστια ποσά ενέργειας, πολλές φορές περισσότερη από τη δημιουργία κειμένου ή εικόνων. Με τα AI-generated βίντεο να βρίσκονται πλέον παντού, το MIT Technology Review παραθέτει τα πάντα γύρω από αυτά.

Πώς παράγεται ένα βίντεο τεχνητής νοημοσύνης

Ας υποθέσουμε ότι είσαι ένας απλός χρήστης. Σήμερα υπάρχουν πολλά εργαλεία υψηλού επιπέδου, που επιτρέπουν σε επαγγελματίες του βίντεο να ενσωματώσουν μοντέλα δημιουργίας βίντεο στις ροές εργασίας τους. Αλλά οι περισσότεροι άνθρωποι θα χρησιμοποιήσουν αυτή την τεχνολογία μέσω μιας εφαρμογής ή ενός ιστότοπου. Η διαδικασία είναι γνωστή: «Gemini, φτιάξε μου ένα βίντεο με ένα μονόκερο να τρώει σπαγγέτι. Τώρα κάνε το κέρατό του να εκτοξευτεί σαν ρουκέτα».

Αυτό που θα πάρεις πίσω θα είναι ενίοτε πετυχημένο και ενίοτε όχι, και συνήθως θα χρειαστεί να ζητήσεις από το μοντέλο να κάνει άλλες προσπάθειες — ίσως 10 φορές — μέχρι να πετύχεις κάτι που να μοιάζει με αυτό που ήθελες.

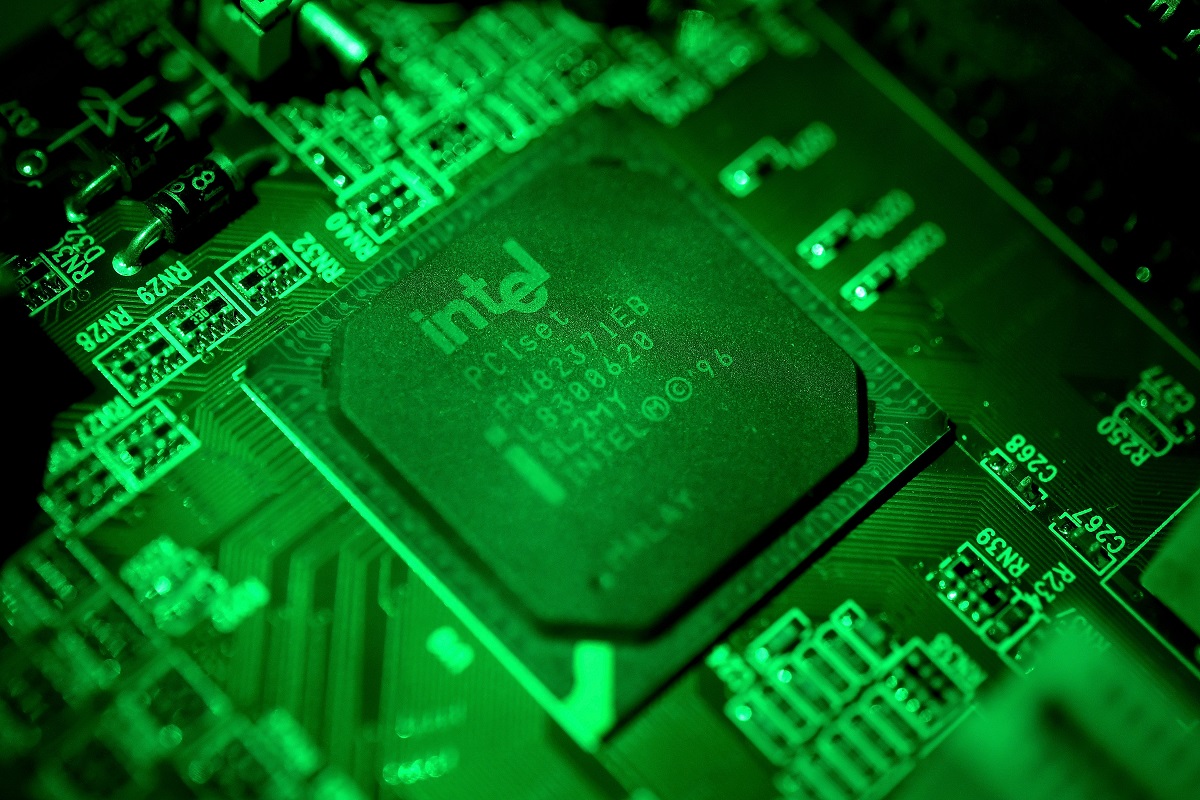

Γιατί τα αποτελέσματα είναι ενίοτε επιτυχημένα και ενίοτε όχι — και γιατί χρειάζεται τόσο μεγάλη ενέργεια; Τα πιο πρόσφατα μοντέλα δημιουργίας βίντεο είναι αυτά που ονομάζονται latent diffusion transformers. Ναι, είναι αρκετά τεχνικός όρος. Ας τα σπάσουμε σε κομμάτια, ξεκινώντας από τη diffusion.

Τι είναι ένα diffusion μοντέλο;

Φαντάσου ότι παίρνεις μια εικόνα και της προσθέτεις τυχαία διασκορπισμένα pixels. Έπειτα παίρνεις αυτή την εικόνα με τα pixels και τη «διασκορπίζεις» ξανά, και ξανά. Αν το κάνεις αρκετές φορές, η αρχική εικόνα μετατρέπεται σε έναν τυχαίο χαμό pixel.

Ένα diffusion μοντέλο είναι ένα νευρωνικό δίκτυο εκπαιδευμένο να αντιστρέφει αυτή τη διαδικασία, μετατρέποντας τον τυχαίο θόρυβο ξανά σε εικόνες. Κατά την εκπαίδευσή του, του δείχνονται εκατομμύρια εικόνες σε διάφορα στάδια pixelation. Μαθαίνει πώς αλλάζουν αυτές οι εικόνες κάθε φορά που προστίθενται νέα pixels και, συνεπώς, πώς να αναιρέσει αυτές τις αλλαγές.

Το αποτέλεσμα είναι ότι όταν ζητήσεις από ένα diffusion μοντέλο να δημιουργήσει μια εικόνα, θα ξεκινήσει με έναν τυχαίο χαμό pixel και βήμα-βήμα θα τον μετατρέψει σε μια εικόνα που μοιάζει περισσότερο ή λιγότερο με τις εικόνες που είδε κατά την εκπαίδευσή του.

Αλλά δεν θέλεις οποιαδήποτε εικόνα — θέλεις την εικόνα που περιέγραψες, συνήθως με ένα text prompt. Γι’ αυτό, το diffusion μοντέλο συνδυάζεται με ένα δεύτερο μοντέλο — όπως ένα μεγάλο γλωσσικό μοντέλο (LLM) εκπαιδευμένο να ταιριάζει εικόνες με περιγραφές κειμένου — που καθοδηγεί κάθε βήμα της διαδικασίας «καθαρισμού», σπρώχνοντας το diffusion μοντέλο προς εικόνες που το LLM θεωρεί καλό ταίριασμα με το prompt.

Μικρή σημείωση: Το LLM δεν «εφευρίσκει» τις σχέσεις μεταξύ κειμένου και εικόνας από το πουθενά. Τα περισσότερα μοντέλα text-to-image και text-to-video σήμερα έχουν εκπαιδευτεί σε τεράστια σύνολα δεδομένων, που περιέχουν δισεκατομμύρια ζεύγη κειμένου-εικόνας ή κειμένου-βίντεο, συλλεγμένα από το διαδίκτυο (μια πρακτική που πολλοί δημιουργοί δεν εγκρίνουν). Αυτό σημαίνει ότι αυτά που παράγουν τα μοντέλα είναι μια αποτύπωση του κόσμου όπως παρουσιάζεται online, συχνά διαστρεβλωμένη από προκαταλήψεις (και πορνογραφικό περιεχόμενο).

Είναι πιο εύκολο να φανταστείς τα diffusion μοντέλα να δουλεύουν με εικόνες. Αλλά η τεχνική μπορεί να χρησιμοποιηθεί σε πολλούς τύπους δεδομένων, συμπεριλαμβανομένου του ήχου και του βίντεο. Για να παραχθούν κινηματογραφικά κλιπ, ένα diffusion μοντέλο πρέπει να «καθαρίσει» σειρές εικόνων — δηλαδή τα διαδοχικά frames ενός βίντεο — αντί για μία μόνο εικόνα.

Τι είναι ένα latent diffusion μοντέλο;

Όλα αυτά απαιτούν τεράστια υπολογιστική ισχύ. Γι’ αυτό τα περισσότερα diffusion μοντέλα που χρησιμοποιούνται για δημιουργία βίντεο εφαρμόζουν μια τεχνική που λέγεται latent diffusion. Αντί να επεξεργάζεται τα ακατέργαστα δεδομένα — δηλαδή τα εκατομμύρια pixels κάθε καρέ βίντεο — το μοντέλο δουλεύει σε έναν latent χώρο, όπου τα καρέ του βίντεο (και το text prompt) συμπιέζονται σε έναν μαθηματικό κώδικα που αποτυπώνει μόνο τα ουσιώδη χαρακτηριστικά των δεδομένων και απορρίπτει τα υπόλοιπα.

Κάτι παρόμοιο συμβαίνει και όταν streamάρεις ένα βίντεο στο διαδίκτυο: ένα βίντεο στέλνεται από έναν server στην οθόνη σου σε συμπιεσμένη μορφή, ώστε να φτάσει πιο γρήγορα, και όταν φτάνει, ο υπολογιστής ή η τηλεόρασή σου το μετατρέπει ξανά σε μορφή που μπορείς να παρακολουθήσεις.

Το τελευταίο βήμα στη δημιουργία βίντεο με latent diffusion είναι να αποσυμπιεστούν τα αποτελέσματα της διαδικασίας. Μόλις τα συμπιεσμένα frames τυχαίου θορύβου μετατραπούν σε συμπιεσμένα frames ενός βίντεο που το LLM θεωρεί καλό ταίριασμα με το prompt του χρήστη, το συμπιεσμένο βίντεο μετατρέπεται σε κάτι που μπορείς να παρακολουθήσεις.

Με το latent diffusion, η διαδικασία λειτουργεί περίπου όπως θα λειτουργούσε για μια εικόνα. Η διαφορά είναι ότι τα pixelated frames του βίντεο είναι τώρα μαθηματικοί κωδικοί αντί για τα καρέ τα ίδια. Αυτό καθιστά το latent diffusion πολύ πιο αποδοτικό από ένα τυπικό diffusion μοντέλο. (Παρόλα αυτά, η δημιουργία βίντεο εξακολουθεί να καταναλώνει περισσότερη ενέργεια από τη δημιουργία εικόνας ή κειμένου, καθώς η υπολογιστική ισχύς που απαιτείται είναι τεράστια.)

Τι είναι ένας latent diffusion transformer;

Υπάρχει ακόμη ένα κομμάτι του παζλ: πώς εξασφαλίζεις ότι η διαδικασία diffusion παράγει συνεχή σειρά καρέ, διατηρώντας αντικείμενα, φωτισμό και άλλα στοιχεία από καρέ σε καρέ. Η OpenAI το πέτυχε με το Sora, συνδυάζοντας το diffusion μοντέλο με ένα άλλο μοντέλο που λέγεται transformer. Σήμερα αυτό έχει γίνει standard στη δημιουργία βίντεο με AI.

Οι transformers είναι εξαιρετικοί στο να επεξεργάζονται μεγάλες ακολουθίες δεδομένων, όπως λέξεις. Αυτό τους καθιστά βασικό στοιχείο σε μεγάλα γλωσσικά μοντέλα, όπως το GPT-5 της OpenAI και το Gemini της Google DeepMind, που μπορούν να παράγουν συνεκτικές ακολουθίες λέξεων σε δεκάδες προτάσεις.

Τα βίντεο όμως δεν αποτελούνται από λέξεις. Αντί γι’ αυτό, τα βίντεο κόβονται σε τμήματα που μπορούν να αντιμετωπιστούν σαν λέξεις. Η προσέγγιση της OpenAI ήταν να «κόψει» τα βίντεο σε χωρικές και χρονικές ενότητες. Όπως λέει ο Tim Brooks, επικεφαλής ερευνητής του Sora: «Είναι σαν να έχεις ένα στοίβο από όλα τα frames ενός βίντεο και να κόβεις μικρούς κύβους από αυτό».

Πλεονεκτήματα των transformers σε συνδυασμό με diffusion

Η χρήση transformers μαζί με diffusion προσφέρει αρκετά πλεονεκτήματα: Βοηθούν το diffusion μοντέλο να διατηρεί συνέπεια στα καρέ καθώς τα παράγει, ώστε αντικείμενα να μην εμφανίζονται ή εξαφανίζονται ξαφνικά. Επειδή τα βίντεο κόβονται σε κομμάτια, το μέγεθος και η κατεύθυνση δεν παίζουν ρόλο. Αυτό σημαίνει ότι τα μοντέλα μπορούν να εκπαιδευτούν σε ποικιλία βίντεο, από σύντομα κάθετα κλιπ κινητού έως widescreen κινηματογραφικά έργα. Η μεγαλύτερη ποικιλία εκπαίδευσης έχει βελτιώσει την παραγωγή βίντεο σε σχέση με πριν δύο χρόνια και επιτρέπει πλέον παραγωγή βίντεο σε διάφορες μορφές.

Τι γίνεται με τον ήχο;

Μια σημαντική πρόοδος με το Veo 3 είναι ότι παράγει βίντεο με ήχο, από συγχρονισμένο διάλογο μέχρι ηχητικά εφέ και θορύβους περιβάλλοντος — κάτι πρωτοφανές για μοντέλα δημιουργίας βίντεο. Όπως δήλωσε ο CEO της Google DeepMind, Ντέμης Χασάμπης, στο Google I/O φέτος: «Βγαίνουμε από την σιωπηλή εποχή της δημιουργίας βίντεο».

Η πρόκληση ήταν να ευθυγραμμιστούν δεδομένα βίντεο και ήχου, ώστε η διαδικασία diffusion να δουλεύει και για τα δύο ταυτόχρονα. Το breakthrough της DeepMind ήταν ένας νέος τρόπος συμπίεσης ήχου και βίντεο σε ένα ενιαίο δεδομένο μέσα στο diffusion μοντέλο. Όταν το Veo 3 δημιουργεί ένα βίντεο, παράγει ήχο και εικόνα ταυτόχρονα, διασφαλίζοντας ότι είναι συγχρονισμένα.

Τα diffusion μοντέλα και τα LLMs

Μπορούν τα LLMs να παράγουν διαφορετικούς τύπους δεδομένων; Όχι — τουλάχιστον όχι ακόμα. Τα diffusion μοντέλα χρησιμοποιούνται κυρίως για εικόνες, βίντεο και ήχο, ενώ τα LLMs — που παράγουν κείμενο, συμπεριλαμβανομένου κώδικα — βασίζονται σε transformers. Αλλά τα όρια γίνονται πιο θολά: βλέπουμε πώς οι transformers πλέον συνδυάζονται με diffusion για παραγωγή βίντεο.

Αυτό το καλοκαίρι, η Google DeepMind αποκάλυψε ότι αναπτύσσει ένα πειραματικό LLM που χρησιμοποιεί diffusion αντί για transformer για παραγωγή κειμένου.

Αποτελεσματικότητα

Εδώ μπερδεύονται τα πράγματα: η παραγωγή βίντεο (με diffusion) καταναλώνει πολλή ενέργεια, αλλά τα diffusion μοντέλα είναι στην πραγματικότητα πιο αποδοτικά από τους transformers. Έτσι, αν ένα LLM χρησιμοποιεί diffusion αντί για transformer για παραγωγή κειμένου, μπορεί να είναι πολύ πιο αποδοτικό από τα υπάρχοντα LLMs.